進化した Docker Compose ではじめる AI エージェント開発 〜ローカル LLM・MCP サーバー・アプリケーションを全て1つの Compose ファイルで〜

はじめに

Docker でソリューションエンジニアをしている根本 征です。

本ブログでは進化した Docker Compose(Agentic Compose) を使った AI エージェント開発方法について紹介します。

近年 AI エージェント開発の需要がとても高くなっており、様々なソリューションやフレームワークが提供されているかと思います。

そのような中で、Docker のソリューションがどのように AI エージェント開発を効率化することができるのか、ご紹介していきます。

目次

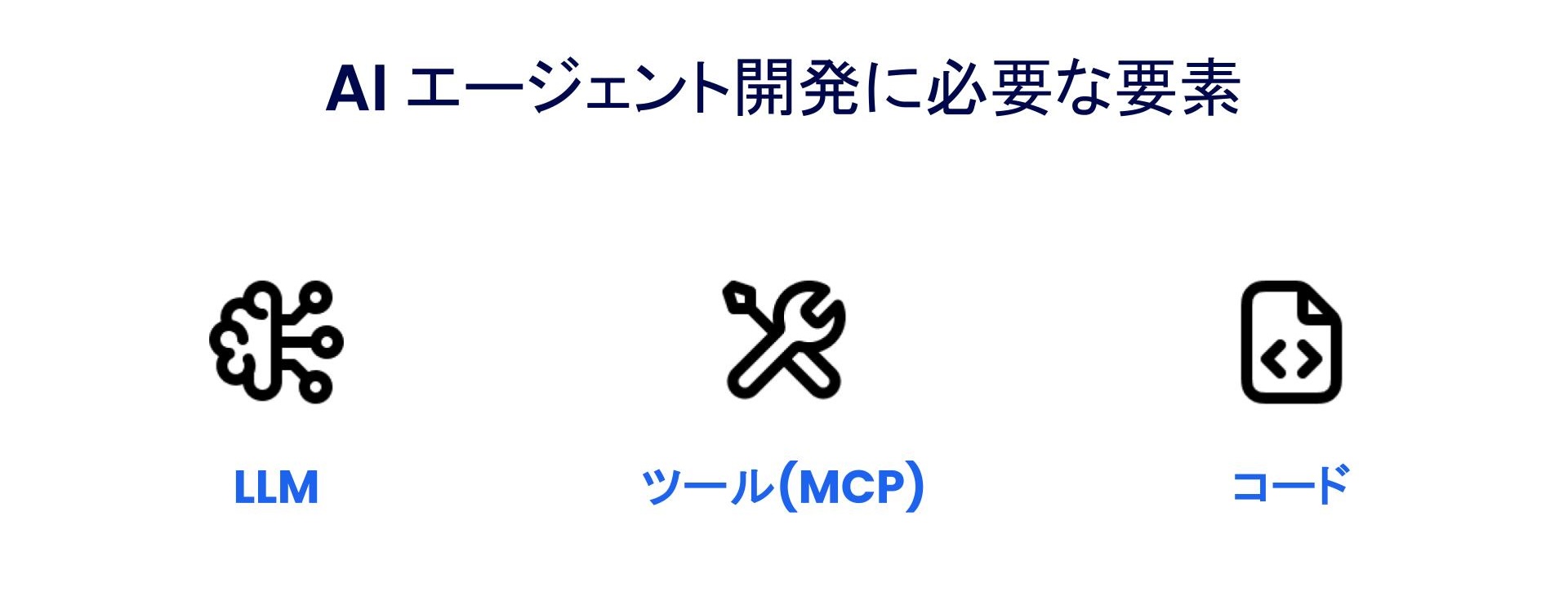

AI エージェント開発に必要な 3つの要素

AI エージェントを開発するにあたって、アプリケーションコードを含めて 3 つの要素が必要だと言われています。

AI エージェント開発に必要な 3つの要素

はじめに LLM が必要になります。

LLM を用意する方法としては、Chat GPT や Claude などの外部 API を利用する、クラウドやオンプレミスの GPU インスタンスを利用する、あるいはローカル環境で LLM を起動させるなど様々な方法があります。

そしてもうひとつが MCP サーバーです。

アプリケーションコードと LLM だけで AI エージェントを構築しようとすると、LLM 単体では取得・操作できる情報に限界があります。

MCP(Model Context Protocol) は AI エージェントが外部ツールとやりとりをするための共通インターフェースになっていまして、現在多くの MCP サーバーが提供されています。

AI エージェントと MCP サーバーを連携することによって、AI エージェントが取得・操作できる情報を大幅に拡張することができます。

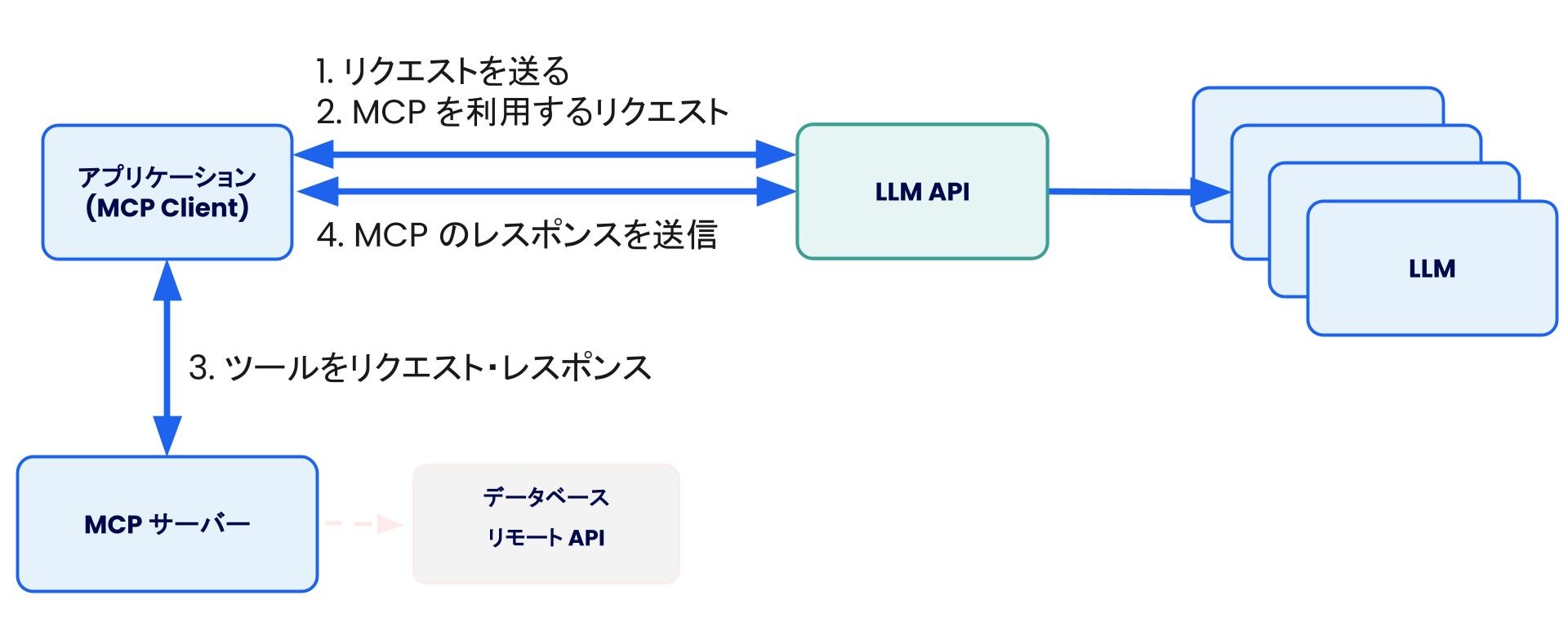

AI エージェントにおける LLM と MCP サーバー

しかし、実際にこれらを組み合わせて AI エージェントを開発しようとすると様々な課題が出てきます。

- LLM・MCP サーバー・AIエージェントフレームワークをどれから選択し、どうそれらを連携すればいいのか

- 複数の開発者で AI エージェントを開発する際に、LLM を含めて開発環境をどう共有すればいいのか

- セキュリティやコスト、ベンダーロックインをどう考慮すればいいのか

このような課題によって、AI エージェント開発がうまく進まなくなってしまうという可能性も出てきます。

また、今後 AI エージェントが Multi-LLM・Multi-Agent になっていくことでより複雑化していくことが予想されます。

このような中で Docker は、新しい技術スタック(AI エージェント開発)おいても、開発者にとって馴染みのある Docker のインターフェースやコンテナ技術を使って、開発できるようにしたいと考えています。

ここからは、Docker を使ってどのように AI エージェント開発をすることができるのかご紹介していきます。

Docker が提供する AI エージェント開発スタック

はじめに Docker は LLM をローカルで実行することができる、いわゆるローカル LLM のソリューションとして Docker Model Runner を提供しています。

Docker Model Runner

- 普段の Docker を使ったコンテナ開発と同じ体験で AI モデルをローカルで実行(docker model pull、docker model run)

- AI モデルを OCI アーティファクトとしてパッケージし、Docker Hub などのコンテナレジストリで共有

- オープンソースのAIモデル、gpt-oss(OpenAI)、llama(Meta)、Gemma(Google)、Qwen(Alibaba Cloud)などを利用可能

- OpenAI API と互換性があるため、アプリケーション側で独自の実装をする必要がなく、SDK やライブラリとシームレスに連携

Docker Model Runner についての詳細は、下記のブログも参考にしていただければと思います。

LLM を簡単にローカルで実行できる Docker Model Runner 〜Docker が提案する新しい生成AIアプリ開発体験〜 | DevOps Hub

次に MCP ですが、Docker ではコンテナ化した MCP サーバーのソリューションとして Docker MCP を提供しています。

Docker MCP Catalog

- MCP サーバーを Docker コンテナで動かすことによって、ホスト上で直接実行するよりも環境依存の減少・セキュリティリスクの削減が期待できる

- Docker MCP Catalog では、150以上の MCP サーバー(Notion、GitHub、Stripe、Grafana など)を Docker Hub にて提供

- Docker によってイメージをビルド・署名・脆弱性スキャン

- コンテナ化した MCP サーバーを管理するゲートウェイとして Docker MCP Gateway をオープンソースで提供

Docker MCP についての詳細は、下記のブログも参考にしていただければと思います。

Docker MCP Catalog and Toolkit ではじめる、コンテナを使った 簡単・安全な MCP サーバーの管理 | DevOps Hub

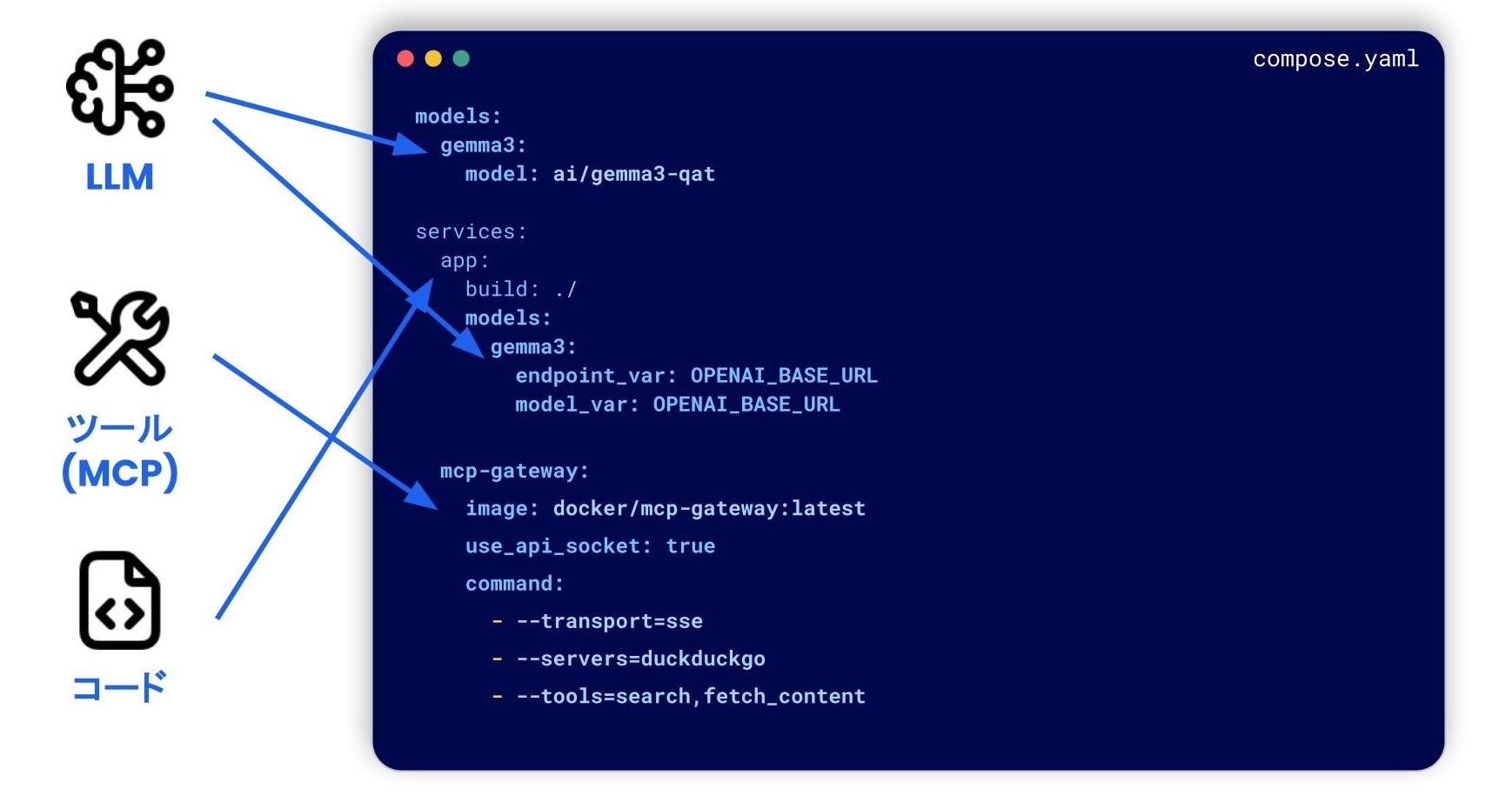

そして 進化した Docker Compose(Agentic Compose) では、Docker Model Runner、Docker MCP、そしてアプリケーションコードを 1つの Compose ファイルにまとめることができます。

"docker compose up" コマンドを実行するだけでこれら AIエージェント開発に必要な環境を一気に立ち上げることができます。

また既存の Docker Compose と同じく、この Compose ファイル 1つのみで簡単に AI エージェント開発環境を他の開発者と共有することができます。

進化した Docker Compose(Agentic Compose)

Agentic Compose は LangGraph、 Vercel AI、 Google の Agent Development Kit、 Spring AI など様々な AI エージェントフレームワークに対応しています。

他のソリューションと違い、Docker コンテナとして実行できるものであれば、特定のフレームワークに依存することなくご利用いただくことができます。

様々な AI エージェントフレームワークに対応

また、Agentic Compose は今後 Cloud Run をはじめとした本番環境にそのままデプロイできるようにもなる予定です。

Google Cloud さんのブログに詳細が書かれていますので、こちらも参考にしていただければと思います。

ローカルホストからリリースまで: Cloud Run と Docker Compose で AI アプリのデプロイを簡素化

ローカル開発と同じ体験で GPUクラウドを活用できる Docker Offload

今回紹介した、Docker Model Runner や Agentic Compose はローカルのGPUリソースを利用することになりますが、状況によってはリソース不足・開発体験を損なってしまうことがあります。

一時的にその処理をクラウド環境に逃す・オフロードすることで開発速度を下げることなく実行することができる Docker Offload をリリースしました。

- NVIDIA L4 の高性能 GPU を利用可能

- 1クリック・1コマンド(docker offload start / stop)でローカル環境とクラウド環境を切り替え

- docker / compose コマンド、バインドマウント、ポートフォワードなどをローカル開発環境と同じ体験で利用可能

Docker Offload

Docker Offload は現在 300分のGPU セッションを無料で使うことができますので、是非お試しください。

おわりに

本ブログでは Docker Compose で新たに利用することができる、AI エージェント開発について解説しました。

Compose ファイル 1つだけで、ローカルLLM・MCP サーバー・アプリケーションを全てまとめることができ、AI エージェント開発環境を簡単に構築、そして他の開発者と共有することができます。

また、Docker Offload を活用することによって、GPUリソースが足りない環境においても、開発体験を損なうことなく AI エージェント開発をすることが可能です。

今後 AI エージェント開発の参考にしていただければ幸いです。

関連リンク

https://www.docker.com/solutions/docker-ai/

https://www.docker.com/blog/build-ai-agents-with-docker-compose/

この記事の著者:根本 征 (Tadashi Nemoto)

Strategic Solutions Engineer

複数の日系企業でテスト自動化エンジニア・DevOpsエンジニアとして活動した後、プリセールスエンジニアとして DevOps、CI/CD、自動テストを中心にお客様の技術支援や技術発信を行ってきました。2024年日本拠点1人目のプリセールスエンジニアとして Docker に入社。

DevOps Hubのアカウントをフォローして

更新情報を受け取る

-

Like on Facebook

-

Like on Feedly